-

OpenClaw“养龙虾”热潮席卷全国:大厂争相入局,安全风险与烧钱陷阱引担忧

这段时间,国内最流行的一阵风就是“养龙虾”,即安装并训练 OpenClaw。 连马化腾都没想到会这么火。 各个大厂争相入局。 继上周的线下免费安装活动后,腾讯又连出三招:企业微信接入 OpenClaw;推出类 OpenClaw 产品 WorkBuddy;同时打造 QClaw 支持一键安装和本地部署。甚至由于 WorkBuddy 国内公开测试上线后,用户访问量…

-

智谱发布AutoClaw“澳龙”:1分钟部署,普通人也能玩转AI Agent

智谱发布AutoClaw“澳龙”:1分钟部署,普通人也能玩转AI Agent 想体验AI智能体(Agent)却苦于部署复杂?现在,一个国产应用让这件事变得极其简单。 其操作界面直观明了: 用户只需输入一句简单的指令,例如: 实时跟进B站、抖音、小红书、GitHub、X、Google、百度、知乎等平台,每隔1小时总结与OpenClaw相关的最新资讯。 任务下达…

-

MLEvolve:12小时登顶MLE-bench榜首,AI自主设计算法能力获突破

让AI像顶尖数据科学家一样设计机器学习算法,需要几步? 上海人工智能实验室“书生”科学发现平台最新开源的 MLEvolve 系统给出了答案:在权威的MLE-bench基准测试中,仅用 12小时 便登顶榜单第一。 MLEvolve是一套自进化的机器学习系统。它采用 渐进式蒙特卡洛图搜索 替代传统树搜索,实现不同探索路径间的经验共享;通过 全局记忆层 记录每一次…

-

谷歌AI教父Jeff Dean预言:未来工程师将管理50个智能体实习生,写需求比写代码更重要

Jeff Dean预言:未来工程师将管理50个智能体,写需求比写代码更重要 谷歌首席AI科学家、传奇工程师Jeff Dean在最新访谈中提出了一个引人注目的预言:未来每位工程师可能会管理多达50个智能体实习生,以并行处理大量任务,且沟通效率将超越人类协作。 他同时指出,未来最重要的技能将是“清晰地定义需求”,因为智能体的输出质量完全取决于人类如何描述和限定问…

-

AI专家级任务评测新标准:百万美元基准揭示模型真实经济价值

如果有价值一百万美元的顶级专家任务,AI 能完成其中多少? 答案是:价值约 48 万美元的任务,而完成这些任务的 API 成本仅需约 100 美元。 这个结论源于 Humanlaya Data Lab 联合北京通用人工智能研究院(BIGAI)、xbench、M-A-P 共同构建的百万美元级评测基准——$OneMillion-Bench。该基准招募了来自摩根士…

-

微软Copilot Cowork深夜炸场:最强Claude接管Office,4.5亿打工人一夜变天!

全球4.5亿办公人士的工作模式,正面临一场剧变。 微软近日推出了全新的办公智能体——Copilot Cowork,旨在深度整合并赋能整个Office生产力套件。这款产品可被视为微软版的“Claude Cowork”。 用户仅需一个简单指令,Copilot Cowork便能横跨Excel、Word、PowerPoint、Outlook等应用,读取相关文件、邮件…

-

LINVIDEO:无需数据重训,视频扩散模型线性化提速20倍,CVPR 2024新突破

无需数据重训,视频扩散模型线性化提速20倍:CVPR 2024新突破 视频生成已进入大规模时代,但随之而来的计算成本急剧攀升。生成一段10秒的视频,其token数量可超过5万,而模型核心的自注意力机制复杂度为O(n²),导致推理过程极其缓慢,难以实用。 将自注意力替换为复杂度为O(n)的线性注意力,是理想的解决方案,但现实情况是:直接替换会导致模型生成质量严…

-

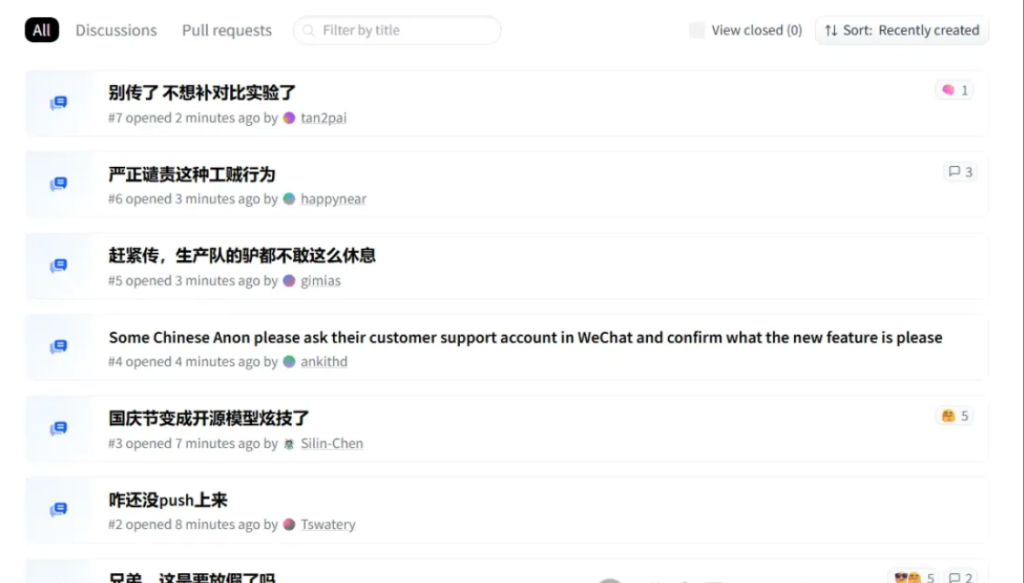

OpenClaw 3.8闪电发布:ACP溯源让AI智能体终于认识你,官方备份工具拯救手滑党

在 OpenClaw 3.7 发布不到24小时后,3.8 稳定版紧随而至。本次更新聚焦于核心功能增强与系统稳定性,主要引入了 ACP 溯源机制以提升智能体交互安全性,并发布了官方备份工具,为关键操作提供保障。 核心更新概览 本次更新主要包含以下四项关键改进: ACP溯源机制:智能体现在能够识别指令来源与权限。 官方备份工具:提供标准化的配置与数据备份方案。 …

-

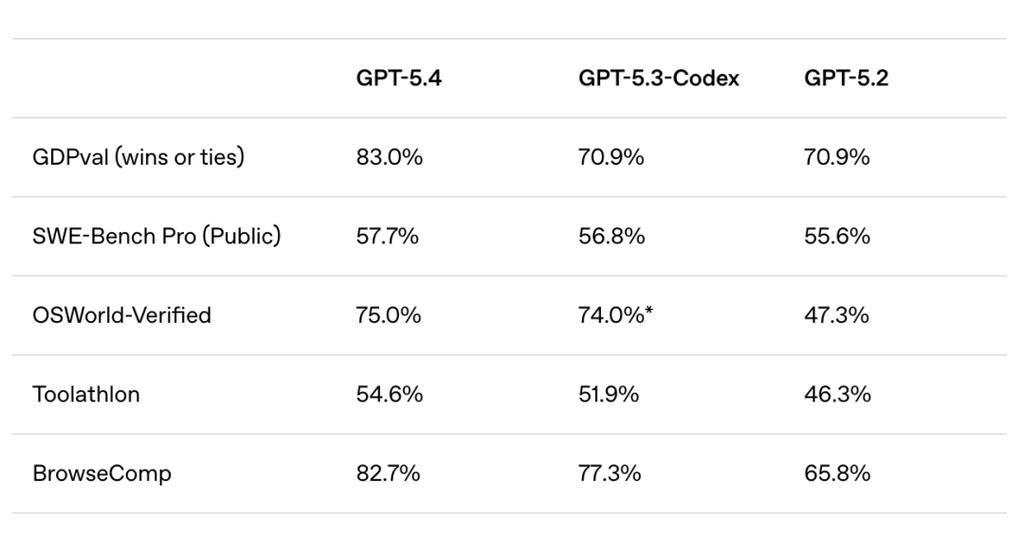

PinchBench基准发布:大模型“养虾”能力大比拼,成功率、速度、成本三维度揭秘各家真实水平

一个评估大模型在“养虾”(OpenClaw)任务中表现的基准——PinchBench,现已正式发布。 该基准获得了OpenClaw项目创始人的关注与转发。 PinchBench智能体评测系统通过真实的成功率、执行速度和运行成本三个维度,综合评估各大模型在OpenClaw实际业务场景中的表现。 需要指出的是,本次评测尚未包含近期发布的新模型,例如谷歌主打性价比…

-

GitHub热榜开源项目The Agency:55个AI专家角色库,打造你的虚拟AI公司

最近,GitHub 趋势榜上出现了一个引人注目的开源项目——The Agency。它本质上是一个AI专家角色库,汇集了55个专业AI角色,并划分为9个部门,涵盖了从工程师、设计师到产品经理、增长黑客等各类常见岗位。 该项目起源于Reddit论坛上的一场讨论。作者发布想法后,短短12小时内便收到超过50位用户的资源请求,进而促成了该项目的诞生。 项目概览:它是…